Existe um fenômeno silencioso acontecendo agora mesmo dentro da sua organização. Enquanto a diretoria discute estratégias de Inteligência Artificial para o futuro, seus colaboradores já implementaram a IA por conta própria no presente. Sem homologação, sem segurança e, muitas vezes, sem o propósito que você imagina. O ganho é para o usuário e o risco é para a empresa!

Isso é Shadow AI. E a forma como as empresas estão lidando com isso oscila entre dois extremos perigosos: a permissividade cega em nome da “produtividade” e o bloqueio total motivado pelo medo.

O mandato “use IA, não importa como”

Pressionados por metas agressivas e pelo hype do mercado, muitos gestores enviaram uma mensagem implícita (ou explícita) aos seus times: “Sejam mais eficientes, usem IA”.

A premissa é que o colaborador usará o ChatGPT ou o Gemini para otimizar códigos complexos ou redigir relatórios estratégicos. A realidade, porém, é bem menos glamourosa.

Ao abrir a caixa de Pandora sem diretrizes claras, as empresas não estão apenas ganhando agilidade; estão perdendo controle. Estudos e análises de tráfego mostram um cenário preocupante: uma parcela significativa do uso de ferramentas de IA Generativa no ambiente corporativo não é para o trabalho.

Estamos vendo colaboradores dedicando horas remuneradas para usar essas ferramentas como “terapeutas digitais” para resolver problemas psicológicos, tirar dúvidas pessoais, planejar viagens ou pesquisar trivialidades. O colaborador sente que está sendo “produtivo” e “digital”, mas, na prática, a empresa está subsidiando uma distração sofisticada.

E o pior: para obter essas respostas “pessoais”, muitas vezes o usuário alimenta a IA com contextos do seu dia a dia profissional, cruzando a linha da privacidade e da segurança de dados sem perceber.

A reação do medo: “bloqueie tudo”

Do outro lado da mesa, temos o CISO ou o Diretor de TI que, ao acordar para os riscos de vazamento de propriedade intelectual (como o famoso caso da Samsung), decide puxar o freio de mão. “Não sei quais riscos estamos expostos, então bloqueie tudo o que for de IA”.

Essa abordagem de “Bunker” é a versão moderna de tentar bloquear a internet nos anos 90. Ela falha por dois motivos:

- A TI Invisível (Shadow IT): Se você bloqueia o acesso na rede corporativa, o colaborador saca o celular pessoal, usa o 4G e continua usando a IA. A diferença é que agora você perdeu completamente a visibilidade do que está sendo trafegado. O dado sai da empresa e não volta.

- Perda de Competitividade: Bloquear a inovação coloca a empresa em desvantagem técnica. Enquanto seu time volta a fazer tudo manualmente, o concorrente que aprendeu a governar (e não proibir) a IA está ganhando velocidade.

O risco real não é a tecnologia, é a cegueira

O problema central do Shadow AI não é a ferramenta em si, mas a falta de governança sobre o fluxo de dados.

Quando um funcionário sobe uma planilha de clientes em uma IA pública para “formatar uma tabela”, ou cola um trecho de código proprietário para “achar um bug”, ele está efetivamente vazando dados confidenciais para servidores de terceiros que, muitas vezes, usam esses dados para retreinar seus modelos públicos.

Estamos trocando segredos industriais por conveniência momentânea.

O caminho do meio: visibilidade e governança

A solução para o dilema do Shadow AI não está nos extremos. Não é sobre liberar geral (e pagar para o funcionário usar a IA como passatempo) nem sobre proibir tudo (e empurrar o risco para dispositivos pessoais). O mercado precisa amadurecer para uma postura de observabilidade. Antes de decidir se bloqueia ou libera, a empresa precisa saber:

- Quem está usando?

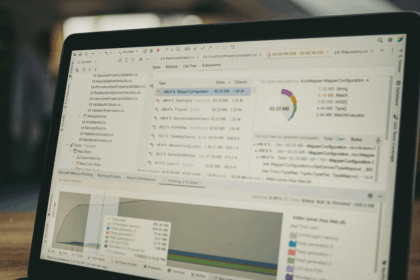

- Quais ferramentas estão sendo acessadas?

- Quais dados estão sendo enviados?

Só com visibilidade é possível criar uma política de uso aceitável que eduque o colaborador, mostrando que a IA é uma ferramenta de trabalho, não um oráculo pessoal e que proteja o ativo mais valioso da organização: a sua informação. Ignorar o Shadow AI não fará o problema desaparecer. Apenas garantirá que, quando o problema estourar, você será o último a saber.